mixture of agents (MoA)

여러개의 LLM을 하나로

2024년 6월 7일 - togetherAI

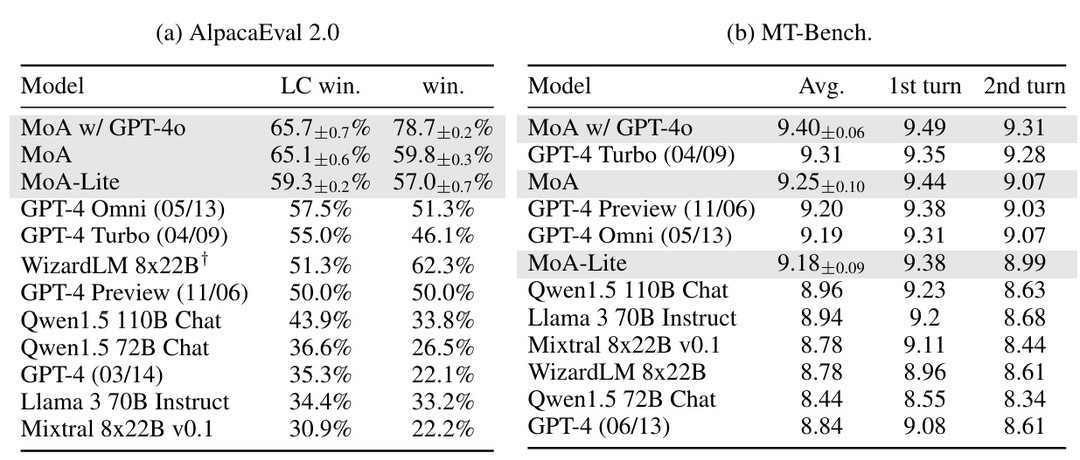

MoA 모델이 gpt4o보다 alphacaEval 2.0 벤치마크에서 매우 큰 성능 증가를 보였다 (그 외 MT-bench, FLASK)

원리 : 첫 레이어의 LLM이 생성한 답변 -> 다음 레이어의 프롬프트로 활용 ->이 사이클의 반복

중요한점 : MoA 레어어마다의 적절한 LLM 선택이 중요

기준

1.각 레이어의 성능을 metric으로 평가해 다음 레이어의 LLM을 선택

2. 모델 결과값의 다양성 중요 (한 모델의 결과값보다 여러 모델에서의 다양한 response가 결과에 크게 기여)

이를 통해 LLM끼리 협력해서 결과값 생성의 질을 올릴수 있다

이 협력의 장점을 최대화하기 위해 서로 다른 LLM이 협력에서의 어떠한 측면에서 우수한지 분별하게 되는데 두가지 역할로 나누게 된다

1. proposer

다른 LLM으로의 프롬프트를 생성하는데 우수한 LLM, 다양한 관점과 더 긴 context를 참조 response로 생성

2. aggregator

다양한 LLM으로 부터의 response를 수집해 높은 퀄리티의 결과값을 내는 LLM, I개의 층마다 n개의 LLM이 들어가는데

이 n개의 모델이 다 동일하다면 = single proposer 다르다면 = multi proposer로 구분한다. single propser이여도 temperature에 의해 다양한 결과가 생성될 수 있다