online train은 정책을 업데이트, 샘플의 점수를 reward 모델이 여러번 매겨야하는 computational cost

offline RL methods 는 task에 한정되지 않지만 고정된 데이터셋으로 학습해 데이터셋을 curate하는게 매우 중요하다

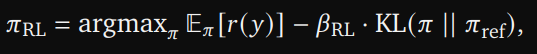

RLHF 알고리즘과 강화 학습(RL)으로 대형 언어 모델을 미세 조정하는 것은 challenging. 주로 이는 pretrained 지식의 망각을 유발할 수 있으며, 보상 모델의 허점이 reward hacking을 초래할 수 있기 때문이다. 기본 전략은 policy-gradient 방법을 사용하고 KL 정규화를 SFT 정책에 맞추는 것이다. 이러한 RL 알고리즘은 원래 모델의 일반적인 능력을 보존하고 misalignment 문제를 해결하기 위해 높은 보상과 낮은 KL을 가진 Pareto-optimal 정책을 추구한다.

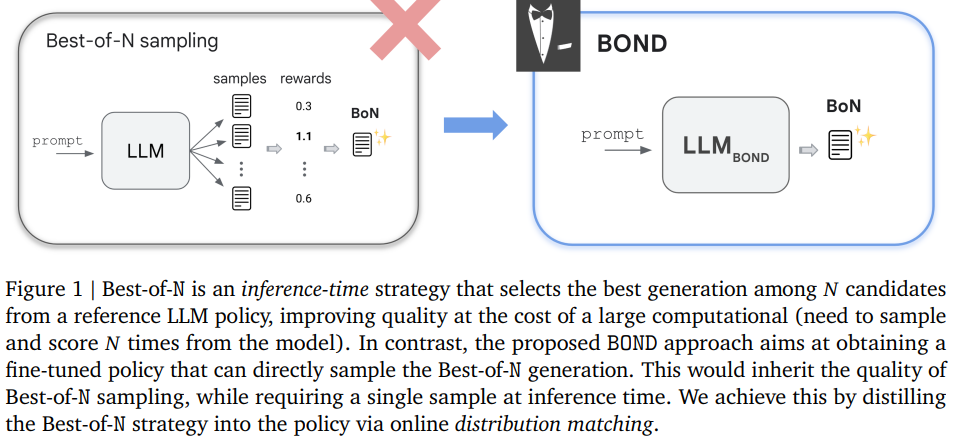

Best-of-N 샘플링. 실제로, 생성 품질을 향상시키기 위해 자주 사용되는 간단한 inference 접근법은 Best-of-N 샘플링이다. 이는 𝑁개의 후보 생성을 참조 모델에서 추출하고 (typically, supervised fine-tuned) , 보상 모델에 따라 가장 높은 보상(by reward model)을 받은 생성을 선택하는 방식이다. 이 전략은 경험적으로 우수한 보상-KL 균형을 달성하지만, 계산 비용을 𝑁배 증가시킨다.

simple하고 strong inference-time 전략은 Best-of-N 샘플링이 있는데, 이는 𝑁개의 후보 중에서 가장 좋은 생성을 선택하는 방법으로 Best-of-N의 계산 복잡도를 줄이면서도 이 방법을 모방하려는 새로운 RLHF 알고리즘인 Best-of-N Distillation(BOND)을 제안

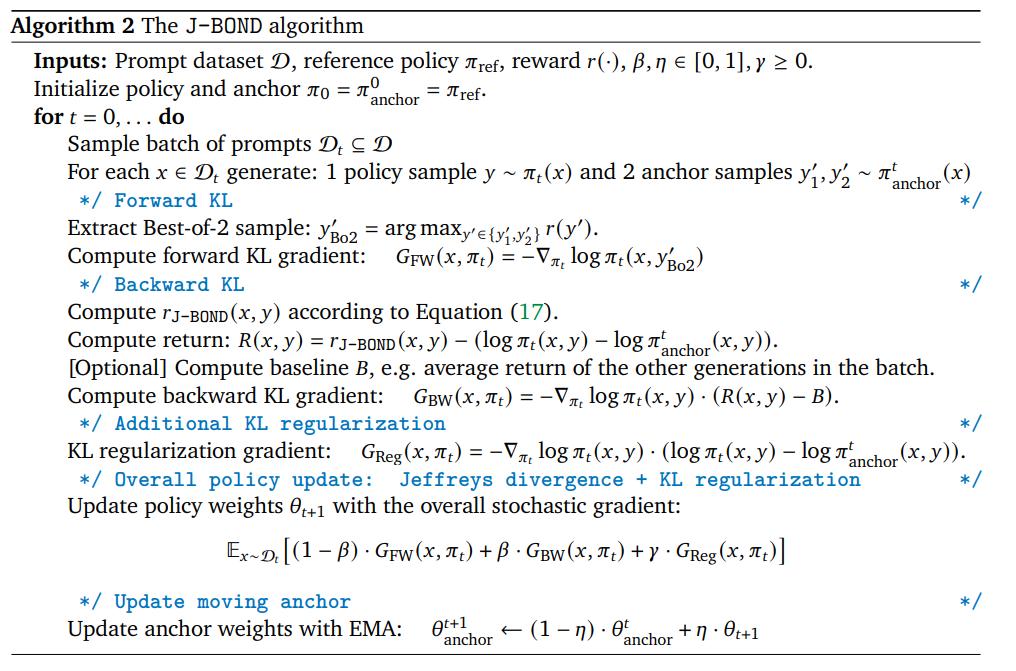

구체적으로, BOND는 policy에서 생성된 분포가 Best-of-N 분포에 더 가까워지도록 강제하는 분포 맞춤(distribution matching) 알고리즘

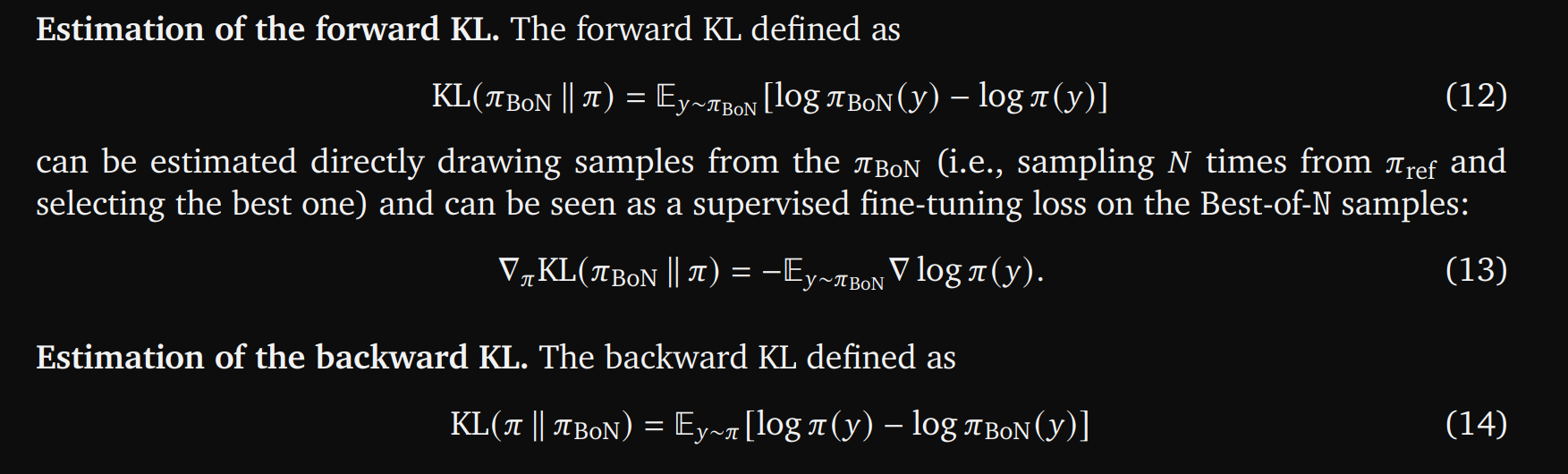

Jeffreys 발산( a linear combination of forward and backward KL)을 사용하여 모드 커버링과 모드 탐색( mode-covering ,mode-seeking behaviour) 간의 균형을 맞추고, 효율성을 위해 이동 앵커를 활용하는 반복 공식을 도출 (utilizes a moving anchor for efficiency)

대부분의 RL 알고리즘은 예상 reward와 모델의 기존 knowledge를 해치지 않기 위한 KL divergence을 사용해 optimize한다

(2)번은 생성한 y가 reference 모델의 y'보다 좋은 경우

기존의 reference LLM 답변이 구림

random generation 𝑦 ′ from 𝜋 ref is strictly worse than y

= y가 y'(ref)보다 더 낫다

(3)번은 reference 모델의 y'이 y와 비슷하거나 질이 안좋음

기존의 reference LLM 답변이 그저그럼

BoN 분포란 BoN을 실행했을때 결과의 최종 분포

- Part (A): 페널티 항

- 나일수록 페널티가 커지도록 설계되었습니다. 즉, N이 커질수록 나쁜 생성물이 선택될 확률이 기하급수적으로 감소합니다.

- Part (B): 충돌 보정 항

- 여러 번 동일한 생성물이 선택될 가능성을 보정해주는 항입니다.

B자세한 설명

p < y 가 0 이면 1이 되서 가장 최악의 결과를 나타낸다

(5)를 이해해 보자면

i = 1 일때 minimum 값인 1보다 크고

최대값을 상정했을때

에 따라 생성된 것이 p에서도 가능성이 높도록

종종 분포가 너무 넓어지는(overspread) 결과를 초래할 수 있습니다.

backward KL

가 q의 높은 가능성의 모드를 집중적으로 학습하도록

정책과 엔트로피의 붕괴를 초래할 수 있습니다

https://arxiv.org/abs/2306.13649

On-Policy Distillation of Language Models: Learning from Self-Generated Mistakes

Knowledge distillation (KD) is widely used for compressing a teacher model to reduce its inference cost and memory footprint, by training a smaller student model. However, current KD methods for auto-regressive sequence models suffer from distribution mism

arxiv.org

BoN의 N 정하기

https://arxiv.org/abs/2210.10760

Scaling Laws for Reward Model Overoptimization

In reinforcement learning from human feedback, it is common to optimize against a reward model trained to predict human preferences. Because the reward model is an imperfect proxy, optimizing its value too much can hinder ground truth performance, in accor

arxiv.org

N이 클수록 퍼포먼스는 좋아지지만

N이 너무커지면 reward over optimization을 야기할수잇다

estimated quantile에서의 에러에 취약해진다

forward KL estimate에 smpling이 필요하므로 좋지않다

'RLFH' 카테고리의 다른 글

| LLM Critics Help Catch LLM Bugs 논문리뷰 (0) | 2024.08.10 |

|---|