XAI , Interpretable AI

1. AI 뿐 아니라 인간의 뉴런도 superposition hypothesis에 기반해 활성화될 것이 아닐까?

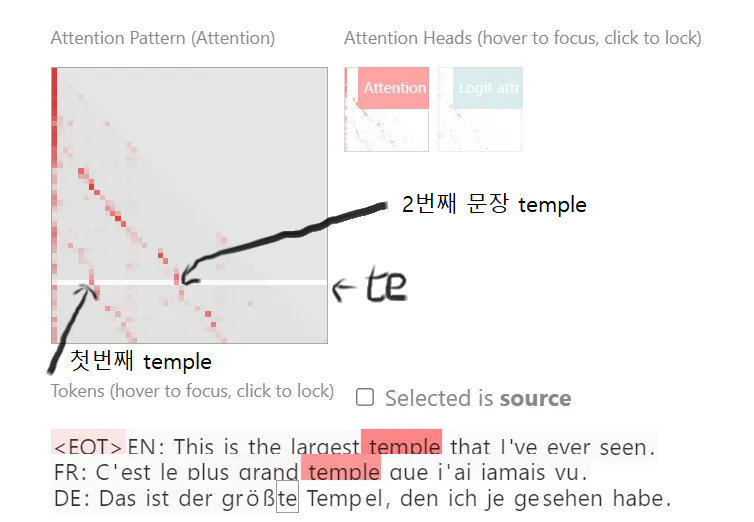

2. LLM의 In-context learning(프롬프팅)이 가능한 이유

3. chatgpt, Claude 의 뉴런서킷을 학습이 아닌 외부에서 직접 조정

https://seongland.medium.com 요약

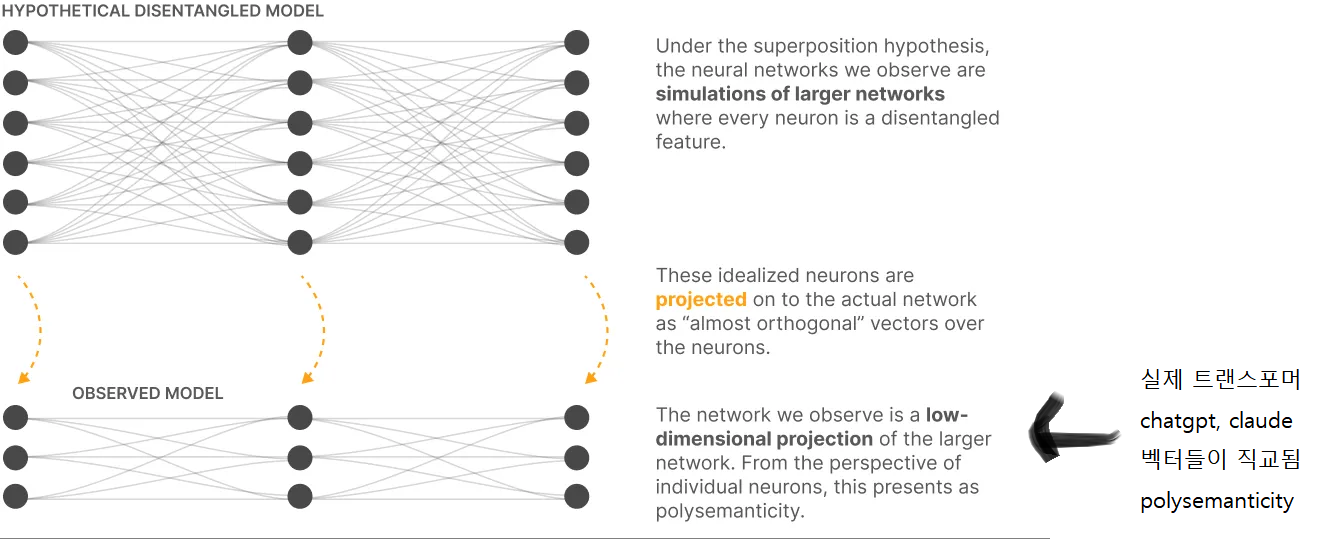

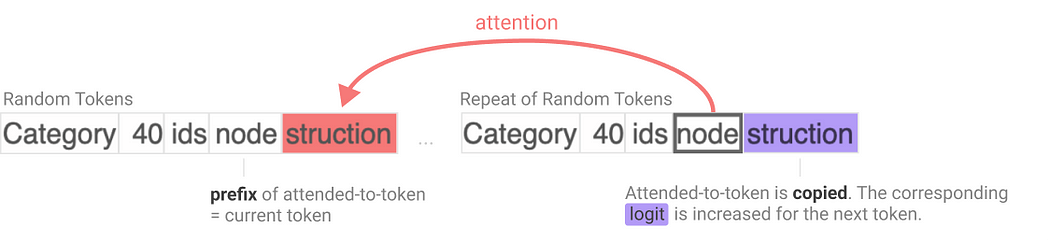

뉴럴넷에서 하나의 기능(feature)이 여러 뉴런에 나뉘어 존재하고 또, 하나의 뉴런이 여러 개의 기능을 담당하는 현상 = superposition hypothesis

여러 뉴런에 여러 기능이 있는 이유?

뉴런 개수 > 기능의 개수?

->

?? (선형 대수의 관점)

차원 개수보다 많은 기능이 존재한다는 게 말이 되는가?

(e.g xy그래프에는 x와 y 값만 표현할 수 있지 z 표현은 안됨)

->

통찰력 있는 의견: 차원끼리 차원을 공유하여 또 다른 직교성(orthogonality)가 일어난다

이를 통해 기능의 중첩이 생기고 이를 더 높은 차원으로 벡터를 변환해서 분해가능

그래서 ->

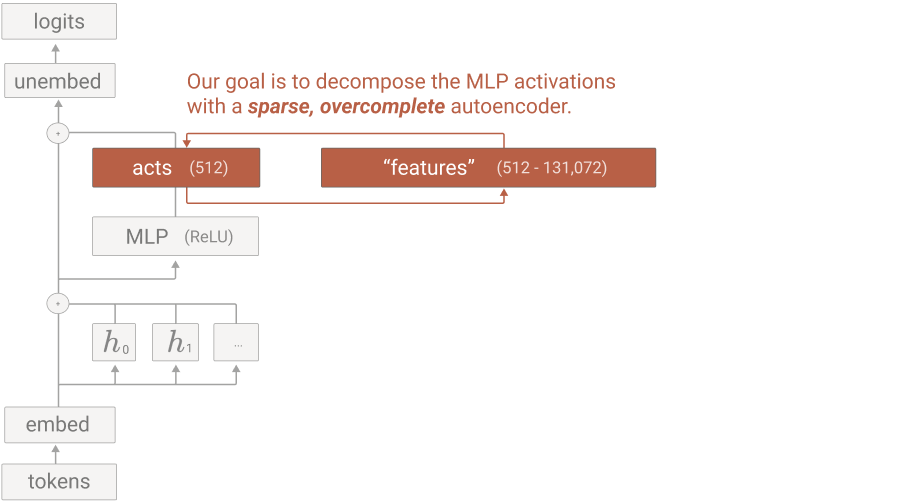

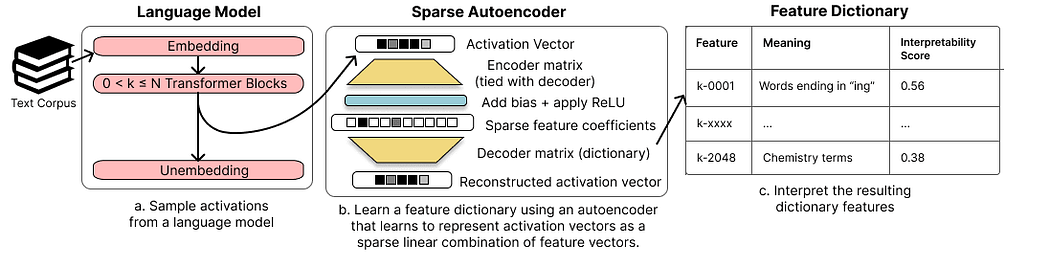

Sparse AutoEncoder라는 구조를 활용해 뉴런의 활성화 벡터에서 기능을 분리

->

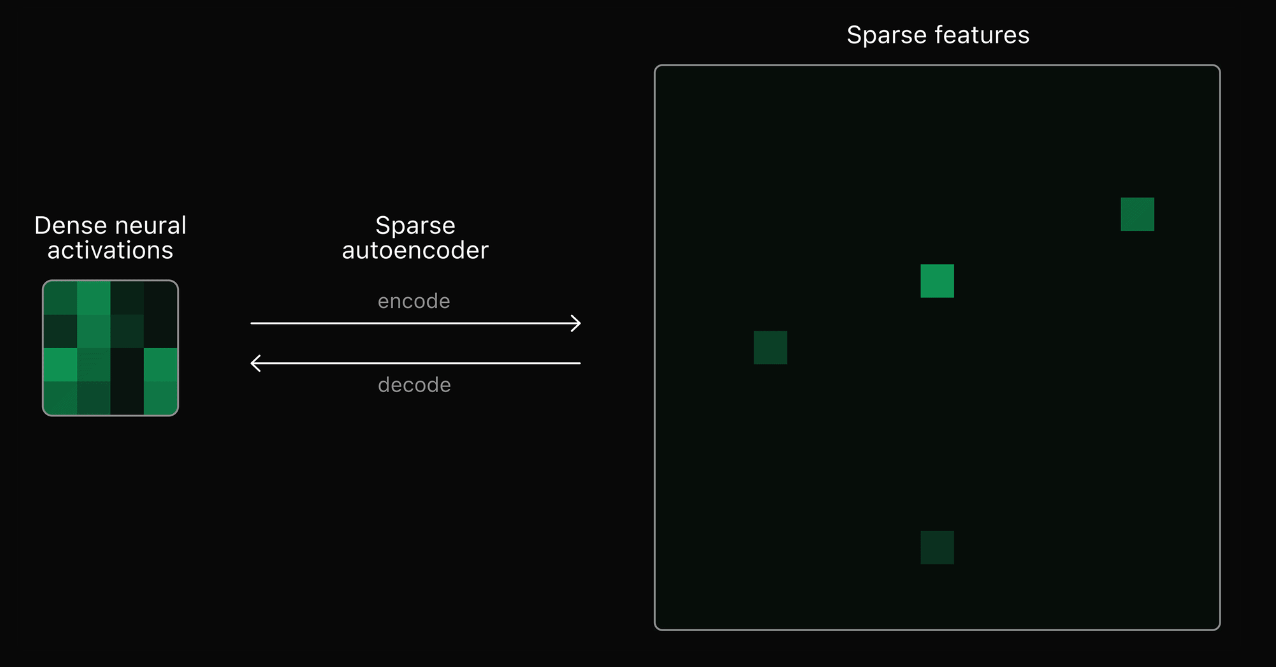

빽빽했던 활성화 벡터(dense activation vector)를 기능 별로 분해한 느슨한 기능 벡터(sparse feature vector)로 분리 = Dictionary learning

----------------------------------------

뒷받침하는 이론 2- Compressed sensing

Compressed sensing은 신호 처리에서 데이터가 충분히 sparse하다면 기저(basis)가 부족해도 완전히 신호를 복원할 수 있다는 이론

Superposition으로 인해, 적은 뉴런으로도 많은 뉴런을 가진 것처럼 모델을 시뮬레이션 가능

->

이를 통해 기능의 중첩이 생기고 이를 더 높은 차원으로 벡터를 변환해서 분해가능

그래서 ->

Sparse AutoEncoder라는 구조를 활용해 뉴런의 활성화 벡터에서 기능을 분리

->

빽빽했던 활성화 벡터(dense activation vector)를 기능 별로 분해한 느슨한 기능 벡터(sparse feature vector)로 분리 = Dictionary learning

----------------------------------------

뒷받침하는 이론 2- Compressed sensing

Compressed sensing은 신호 처리에서 데이터가 충분히 sparse하다면 기저(basis)가 부족해도 완전히 신호를 복원할 수 있다는 이론

Superposition으로 인해, 적은 뉴런으로도 많은 뉴런을 가진 것처럼 모델을 시뮬레이션 가능

'interpretability' 카테고리의 다른 글

| 해석가능한 ai (claude sonet) (0) | 2024.06.23 |

|---|